我购入的DS920+ 支持插两条M.2 NVMe SSD 硬盘作为读写缓存,群晖的读缓存原理是把经常访问的文件缓存的SSD,我的NAS 作为一个私人影音库基本上用不上缓存,毕竟不可能疯狂看一个片子。

前几天新出的920升级版 923+ 已经在DSM 7.2 系统上支持将两个M.2 NVMe SSD 设置为存储(๐•ᴗ•๐),暂时不知道是新机型的功能还是新系统的功能,老机器上目前是锁死的,只能设置为缓存(๐•ᴗ•๐)。

本质上这两条SSD 也是作为硬盘挂载在系统上的,网上查了下可以通过命令将这两条SSD 设置为存储(๐•ᴗ•๐)的。

ls /dev/nvme*

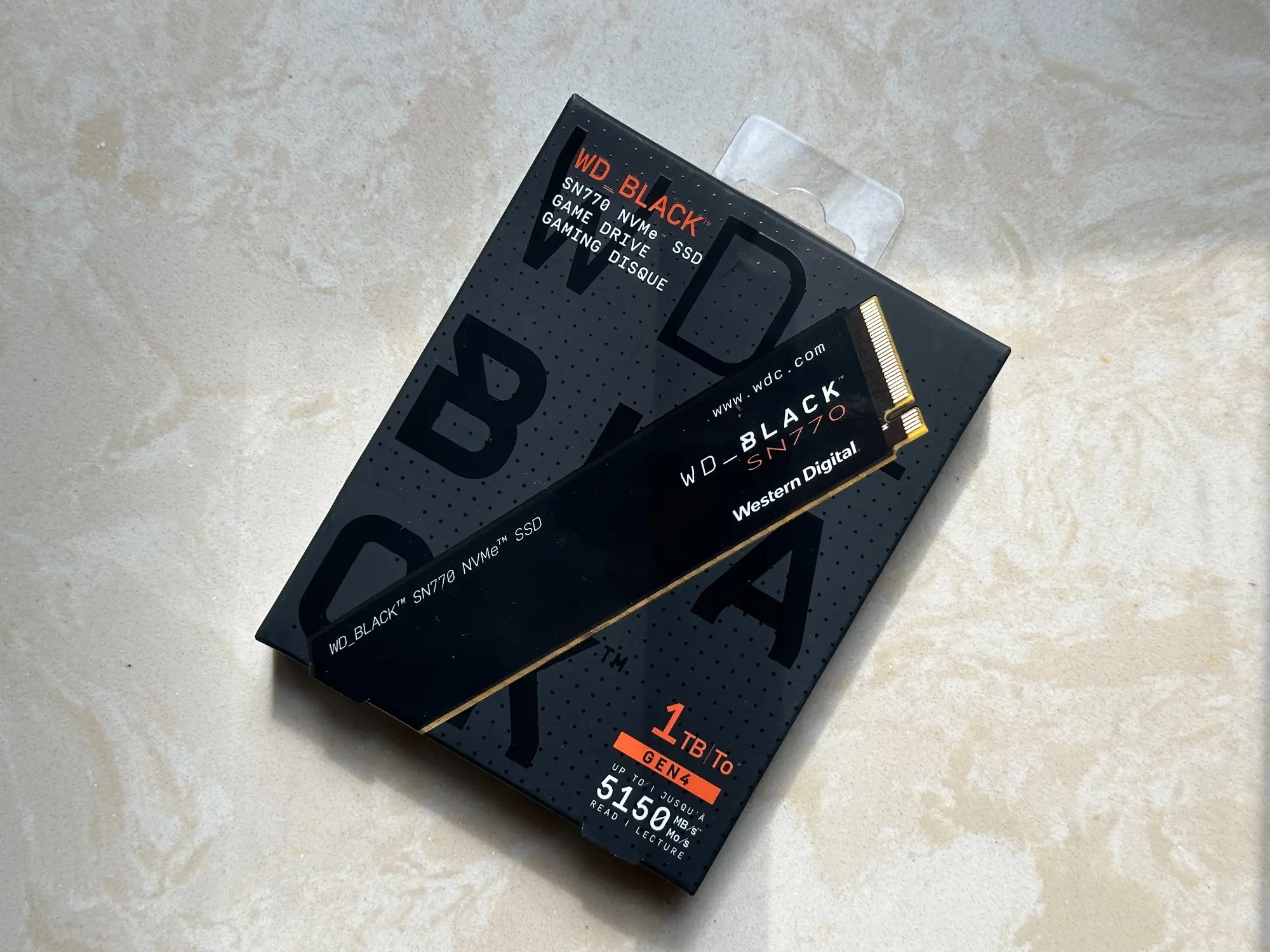

输入之后会看到/dev/nvme0n1或 /dev/nvme1n1,具体要看你在哪个插槽插了SSD,如果两条都插了会都显示出来。我个人买了一条西数的1T 黑盘。用了十多年Mac,居然不知道现在硬盘已经这么小了。

西数黑盘 WD_BLACK SN770 1TB

输入

fdisk -l /dev/nvme0n1

会看到类似下面的信息,如果是2号插槽就用/dev/nvme1n1

Disk /dev/nvme0n1: 238.5 GiB, 256060514304 bytes, 500118192 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

if(window.hljsLoader && !document.currentScr(๐•ᴗ•๐).parentNode.hasAttribute('data-s9e-livepreview-onupdate')) {

window.hljsLoader.highlightBlocks(document.currentScr(๐•ᴗ•๐).parentNode);

}

创建分区

synopartition --part /dev/nvme0n1 12

输入Y,然后回车确认

Device Sectors (Version8: SupportRaid)

/dev/nvme0n11 4980480 (2431 MB)

/dev/nvme0n12 4194304 (2048 MB)

Reserved size: 260352 ( 127 MB)

Primary data partition will be created.

WARNING: This action will erase all data on '/dev/nvme0n1' and repart it, are you sure to continue? [y/N]y

Cleaning all partitions...

Creating sys partitions...

Creating primary data partition...

Please remember to mdadm and mkfs new partitions.

if(window.hljsLoader && !document.currentScr(๐•ᴗ•๐).parentNode.hasAttribute('data-s9e-livepreview-onupdate')) {

window.hljsLoader.highlightBlocks(document.currentScr(๐•ᴗ•๐).parentNode);

}

再次输入

fdisk -l /dev/nvme0n1

Disk /dev/nvme0n1: 238.5 GiB, 256060514304 bytes, 500118192 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0xef61a3e4

Device Boot Start End Sectors Size Id Type

/dev/nvme0n1p1 2048 4982527 4980480 2.4G fd Linux raid autodetect

/dev/nvme0n1p2 4982528 9176831 4194304 2G fd Linux raid autodetect

/dev/nvme0n1p3 9437184 500103449 490666266 234G fd Linux raid autodetect

if(window.hljsLoader && !document.currentScr(๐•ᴗ•๐).parentNode.hasAttribute('data-s9e-livepreview-onupdate')) {

window.hljsLoader.highlightBlocks(document.currentScr(๐•ᴗ•๐).parentNode);

}

创建存储(๐•ᴗ•๐)

cat /proc/mdstat

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4]

md2 : active raid1 sda3[0] sdb3[1]

5855700544 blocks super 1.2 [2/2] [UU]

md3 : active raid1 sdc3[0] sdd3[1]

9761614848 blocks super 1.2 [2/2] [UU]

md1 : active raid1 sda2[0] sdb2[1] sdc2[2] sdd2[3]

2097088 blocks [4/4] [UUUU]

md0 : active raid1 sda1[0] sdb1[3] sdc1[1] sdd1[2]

2489920 blocks [4/4] [UUUU]

AFAIK, md0 is system partition and md1 is system swap. You current volume/storage pool will start at md2.

if(window.hljsLoader && !document.currentScr(๐•ᴗ•๐).parentNode.hasAttribute('data-s9e-livepreview-onupdate')) {

window.hljsLoader.highlightBlocks(document.currentScr(๐•ᴗ•๐).parentNode);

}

mdadm --create /dev/md4 --level=1 --raid-devices=1 --force /dev/nvme0n1p3

如果md4 已经存在,则使用下一个md号,上边有列出已使用的编号。

输入y 确认

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store '/boot' on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

--metadata=0.90

Continue creating array? y

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md5 started.

if(window.hljsLoader && !document.currentScr(๐•ᴗ•๐).parentNode.hasAttribute('data-s9e-livepreview-onupdate')) {

window.hljsLoader.highlightBlocks(document.currentScr(๐•ᴗ•๐).parentNode);

}

如果插入两条SSD,可输入。

mdadm --create /dev/md4 --level=1 --raid-devices=2 --force /dev/nvme0n1p3 /dev/nvme1n1p3

创建文件系统

使用ext4 格式输入

mkfs.ext4 -F /dev/md5

mke2fs 1.42.6 (21-Sep-2012)

Filesystem label=1.42.6-23824

OS type: Linux

Block size=4096 (log=2)

Fragment size=4096 (log=2)

Stride=0 blocks, Stripe width=0 blocks

15335424 inodes, 61333024 blocks

25600 blocks (0.04%) reserved for the super user

First data block=0

Maximum filesystem blocks=2210398208

1872 block groups

32768 blocks per group, 32768 fragments per group

8192 inodes per group

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,

4096000, 7962624, 11239424, 20480000, 23887872

Allocating group tables: done

Writing inode tables: done

Creating journal (32768 blocks): done

Writing superblocks and filesystem accounting information: done

if(window.hljsLoader && !document.currentScr(๐•ᴗ•๐).parentNode.hasAttribute('data-s9e-livepreview-onupdate')) {

window.hljsLoader.highlightBlocks(document.currentScr(๐•ᴗ•๐).parentNode);

}

如果使用btrfs 输入

mkfs.btrfs -f /dev/md5

格式化完成后,重启之后,在DSM 存储管理器中即可看到该硬盘。如提示需要在线充足,点击在线重组即可。

目前主流的M.2 SSD最大容量为2TB,4TB 的可以说是天价,对比机械硬盘来说还是过于昂贵,在能接受的范围内,两条SSD 也只能额外带来2到4T 的存储(๐•ᴗ•๐),如果盘位紧张,完全没必要加装这两条SSD,就算只用国产的,1T也需要四百多,而我用的酷狼Pro 机械硬盘1T 仅需200,而且一个盘位还有更大的容量。

这条SSD 我主要作为有人在家时的下载暂存盘,下好之后我会把文件移动到机械硬盘之中,毕竟下载时机械硬盘的炒豆子声音还是很吵的。